本文最后更新于 75 天前,其中的信息可能已经有所发展或是发生改变。

在给老板们部署模型的时候,经常有问Ollama能不能部署,轻量,就去搞了一下

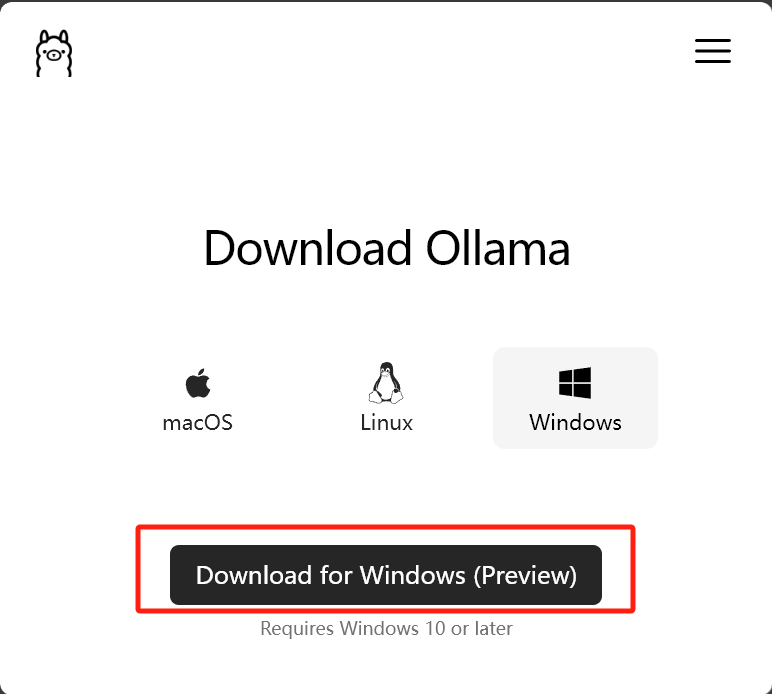

安装本体

打开:Download Ollama on Windows,点击下载Winodws预览版本,得到OllamaSetup.exe安装文件。

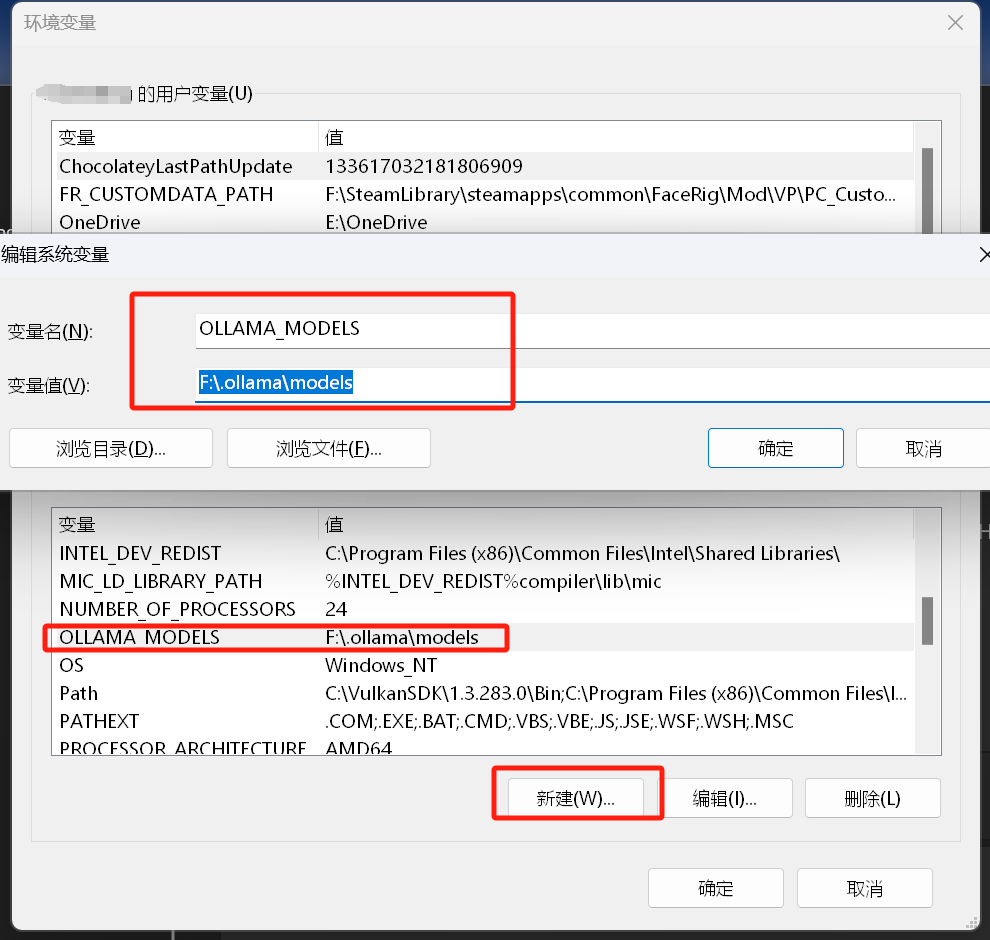

先别急着安装,默认情况下,ollama模型的存储目录如下:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\<username>\.ollama\models

如果需要使用不同的目录,则需设置环境变量OLLAMA_MODELS, 把它设置为所选目录。

https://github.com/ollama/ollama/blob/main/docs/faq.md

然后OllamaSetup.exe安装文件运行后会自动安装Ollama,安装完成后会在右下角状态栏跳出一个羊驼图标,就是它。

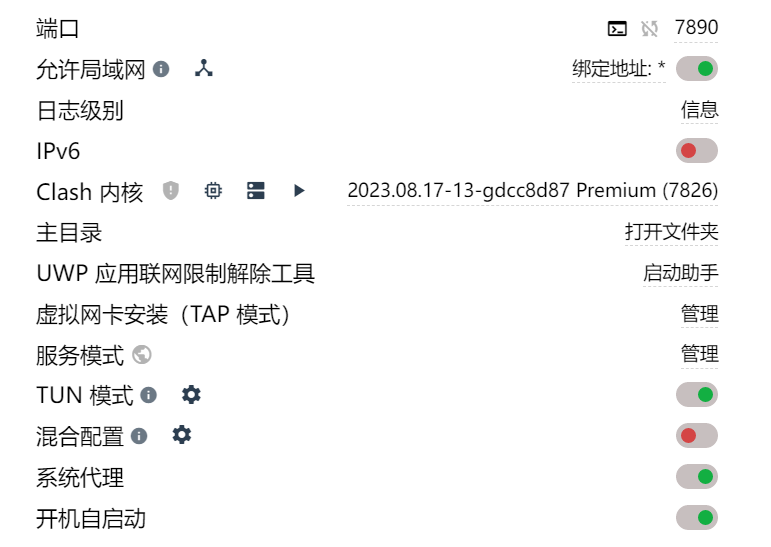

另外可以通过添加以下环境变量修改接口的IP端口地址:

OLLAMA_HOST=0.0.0.0:11434安装模型

模型网址:Ollama

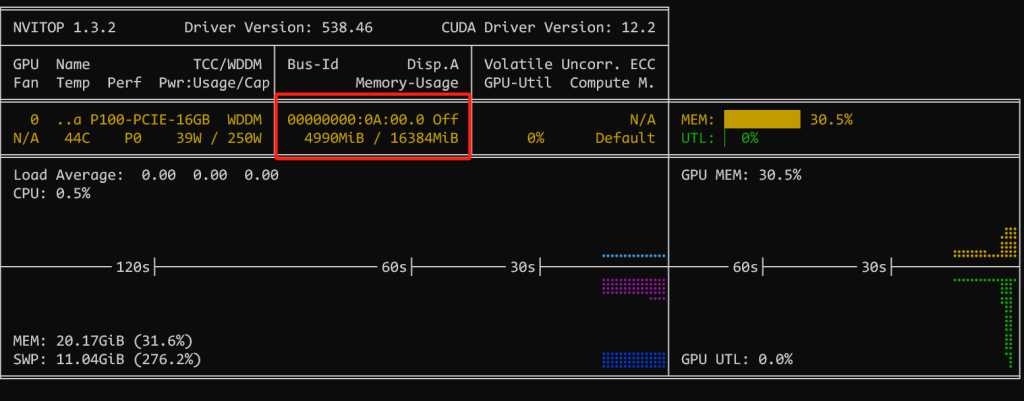

我们这边选新出的Qwen2,默认是7B的,我试了下,显存占用不高,4.9G≈5G

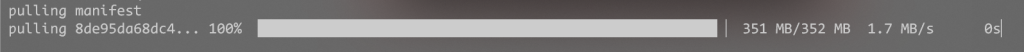

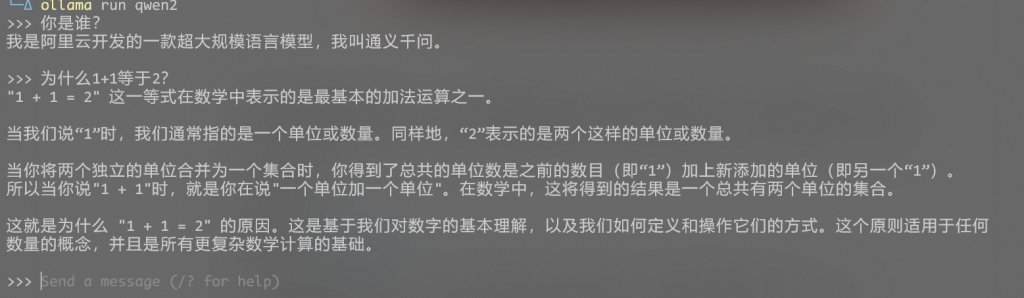

新建终端,运行以下命令会自动下载7b模型并加载,加载后就可以在终端中跑文字对话。

ollama run qwen2

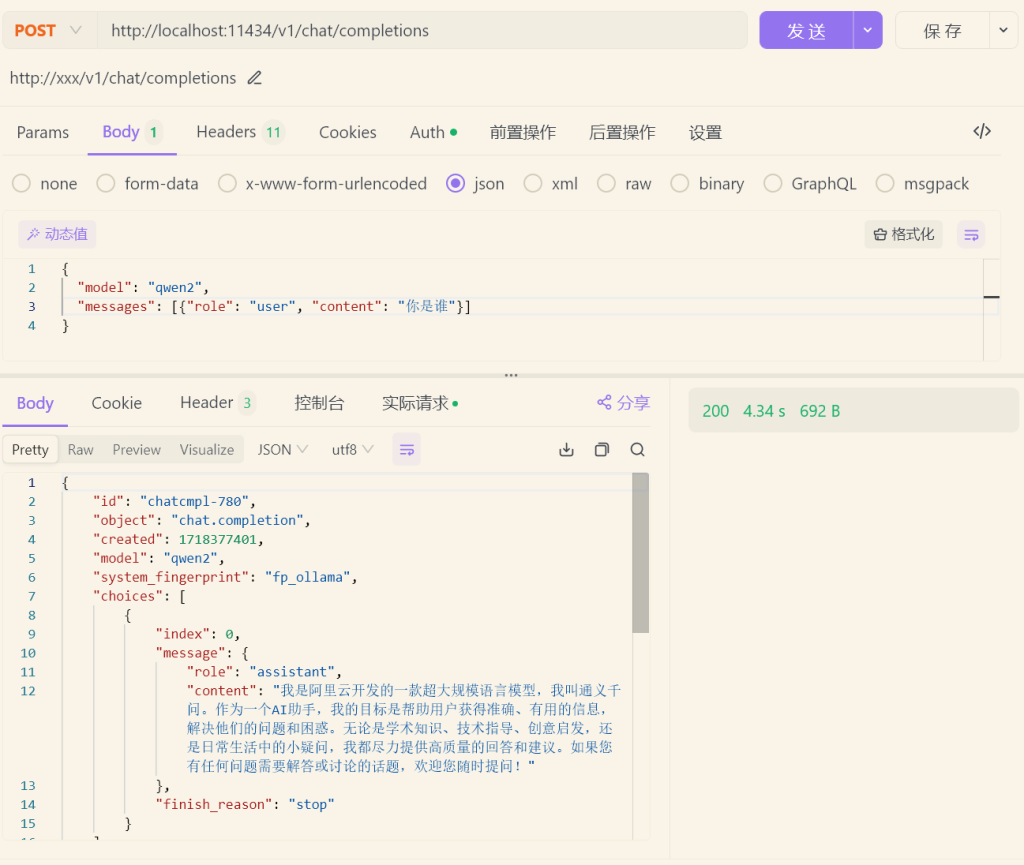

接口调用

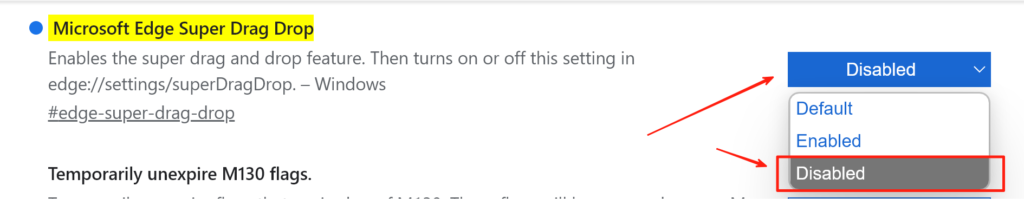

接口地址为http://localhost:11434,如下图所示,因此只需要将某些软件的AI代理设置为http://localhost:11434即可。

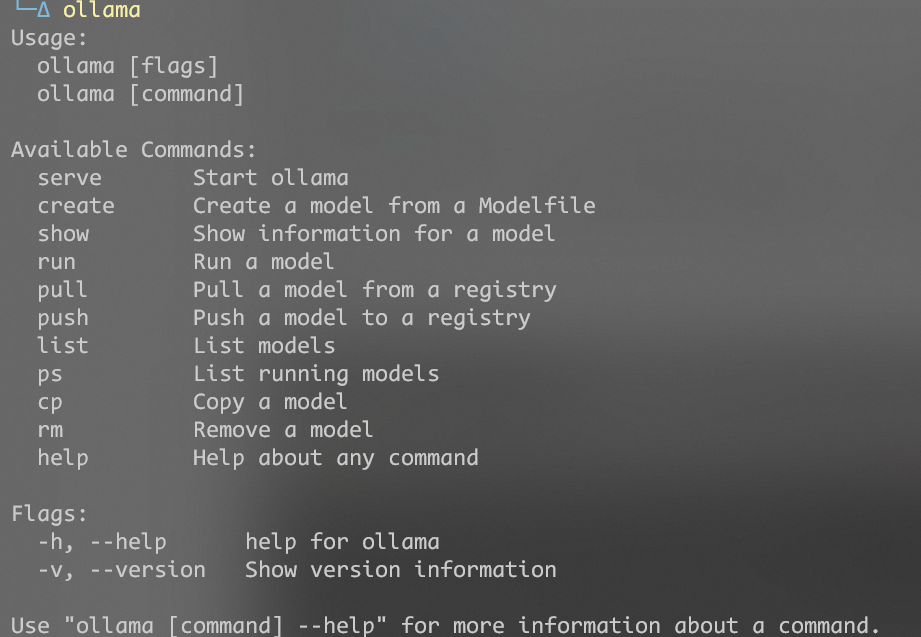

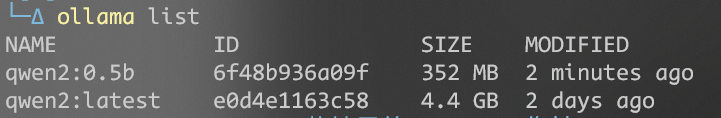

ollama命令

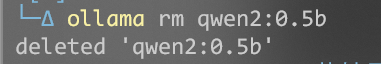

删除模型

附:ollama越下越慢的方法

创建文件 ollama_download.ps1

while ($true) {

# 启动ollama命令作为后台进程,并获取其PID

$process = Start-Process -FilePath "C:\Users\Administrator\AppData\Local\Programs\Ollama\ollama.exe" -ArgumentList pull,deepseek-r1 -PassThru

$CMD_PID = $process.Id

Write-Output "启动的进程ID:$CMD_PID"

# 等待60秒

Sleep 60

# 强制终止进程

Stop-Process -Force -Id $CMD_PID

# 等待5秒

Sleep 5

}