本文最后更新于 428 天前,其中的信息可能已经有所发展或是发生改变。

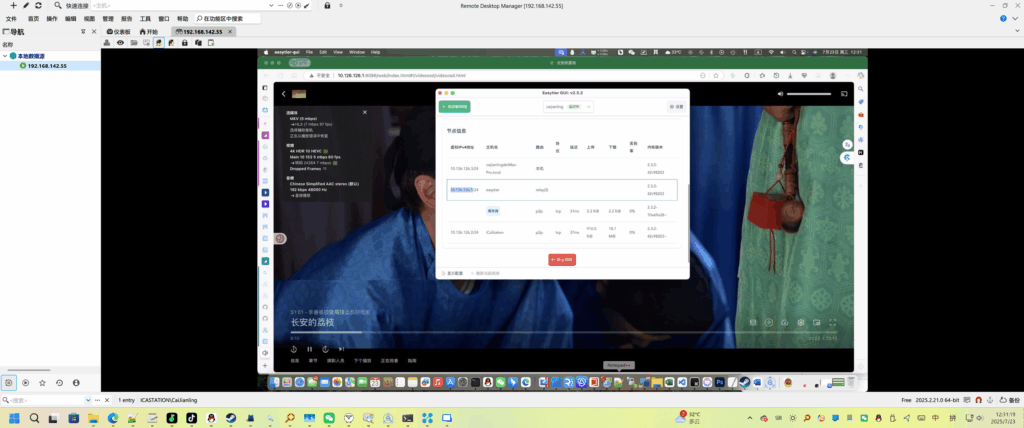

先上结果:

准备

1、BOIS开启虚拟化、系统中开启虚拟化和WSL功能。

相关教程:【教程】wsl命令报错:命令行选项无效的处理方法 – iTPno.、【笔记】Windows部署DockerDesktop问题 – iTPno.

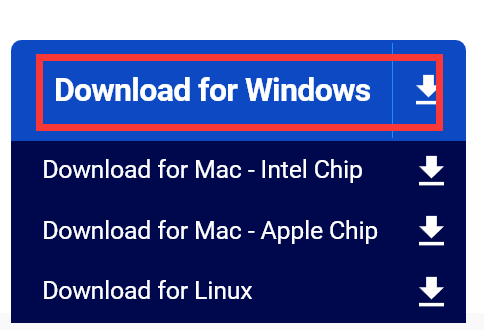

2、安装Docker Desktop。

下载一个配置文件1←点击脚注。

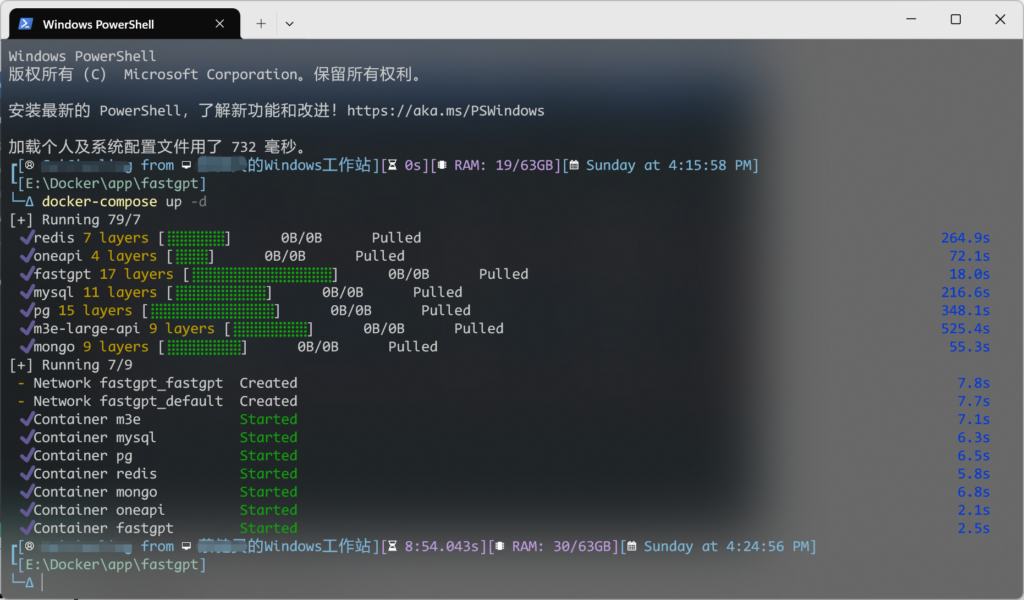

在配置文件目录中执行(拉取镜像、部署镜像):

如果有N卡则将配置文件中显卡注释去除

# 有N卡的加上这段

deploy:

resources:

reservations:

devices:

- driver: "nvidia"

count: "all"

capabilities: ["gpu"]docker-compose pull && docker-compose up -d

# 或者直接执行

docker-compose up -d

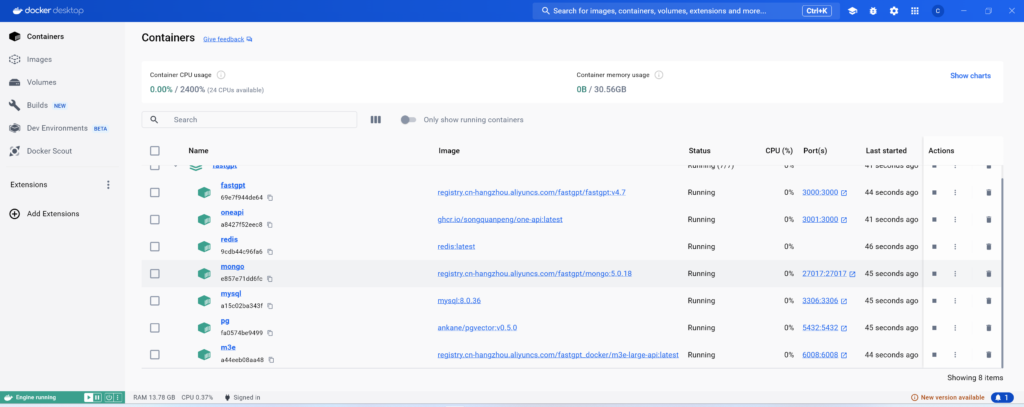

正常没问题就会在Docker Desktop中看到这个:

配置OneApi

打开localhost:3001或直接点击one-api后面的Port(s)的链接打开OneApi应用。

部署本地Ollama的相关教程:【教程】本地Ollama部署模型[Windows] – iTPno.

免费逆向API方案:LLM Red Team

点击登录,账号root,密码123456。

系统默认就有一个超级令牌:

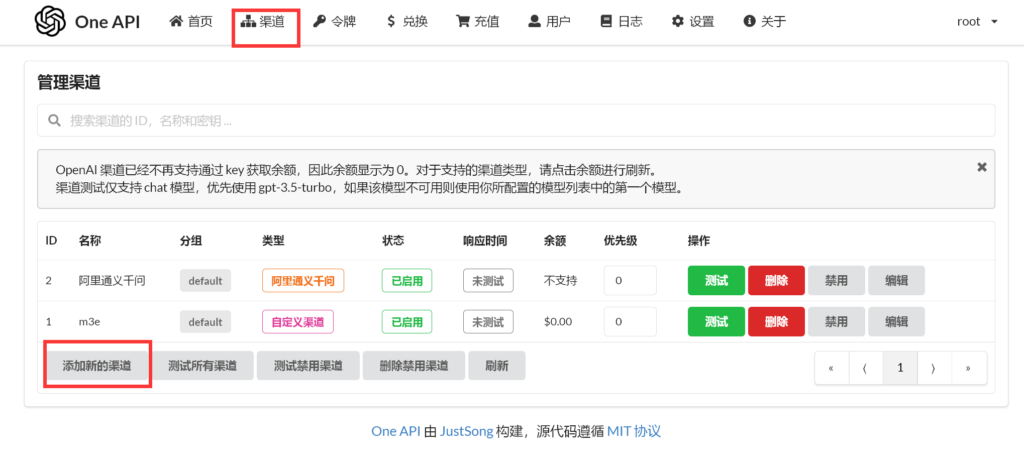

添加M3E向量模型,用于知识库的索引模型

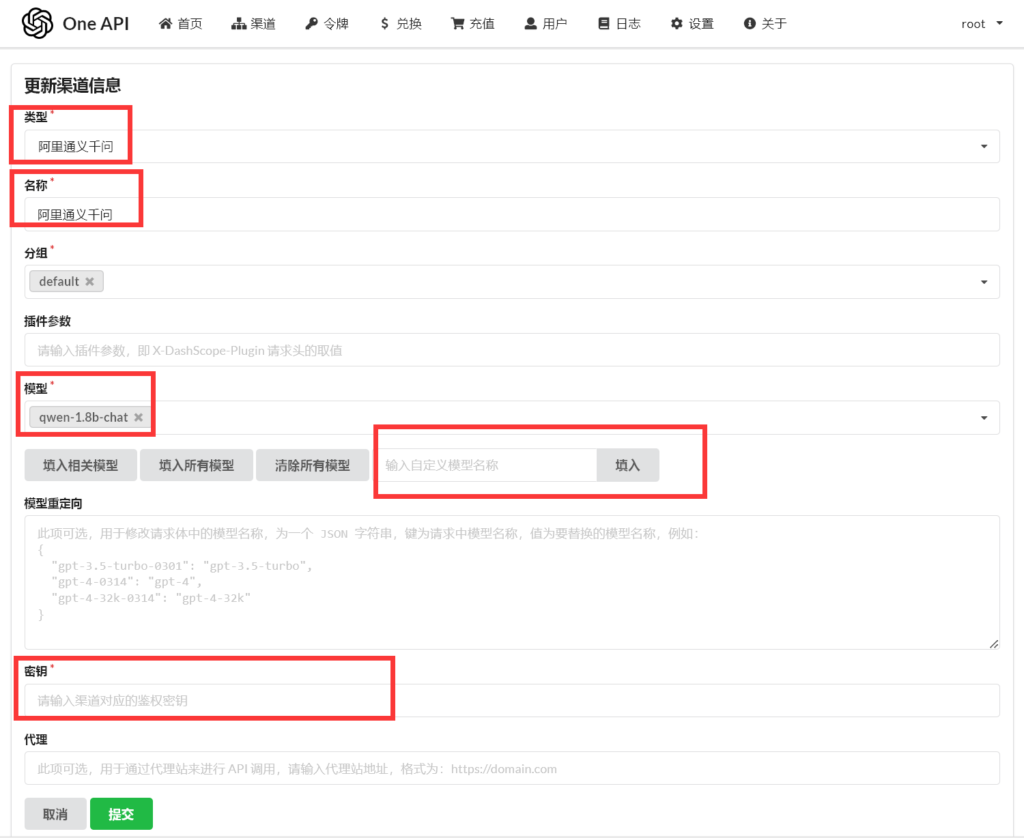

渠道-添加新的渠道

按照下图填入

按需配置自己的模型

在下面有例子

配置FastGPT

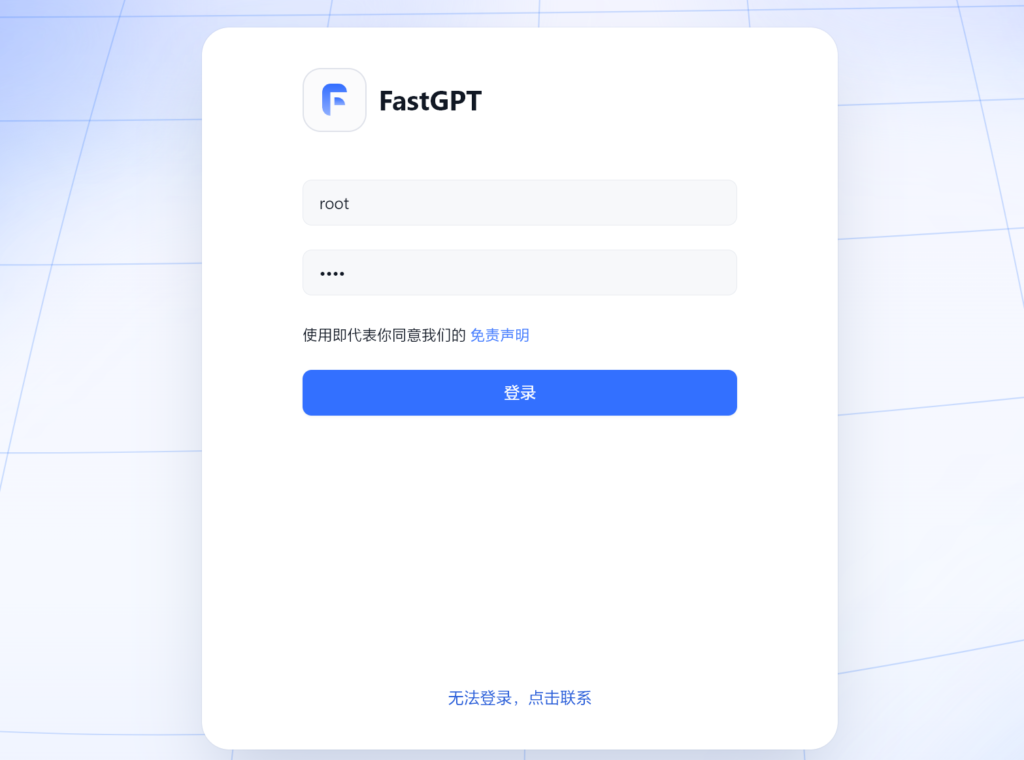

点开本机的localhost:3000或者点开fastgpt应用端口,登录默认账号,账号root,密码1234:

如果出现无法登录的情况,进入docker的mongo bash(初始化复制集)

# mongo

...

> use admin

switched to db admin

>rs.initiate({

_id: "rs0",

members: [

{ _id: 0, host: "mongo:27017" }

]

})

{"ok": 1}

> db.createUser(

{

user: "myname",

pwd: "mypassword",

roles: [ { role: "root", db: "admin" } ]

}

)

Successfully added user: {

"user" : "myname",

"roles" : [

{

"role" : "root",

"db" : "admin"

}

]

}

> db.auth("myname","mypassword")

1返回1则成功

添加FastGPT、OneApi接口信息

进入OneApi,渠道,添加渠道:

我的例子:

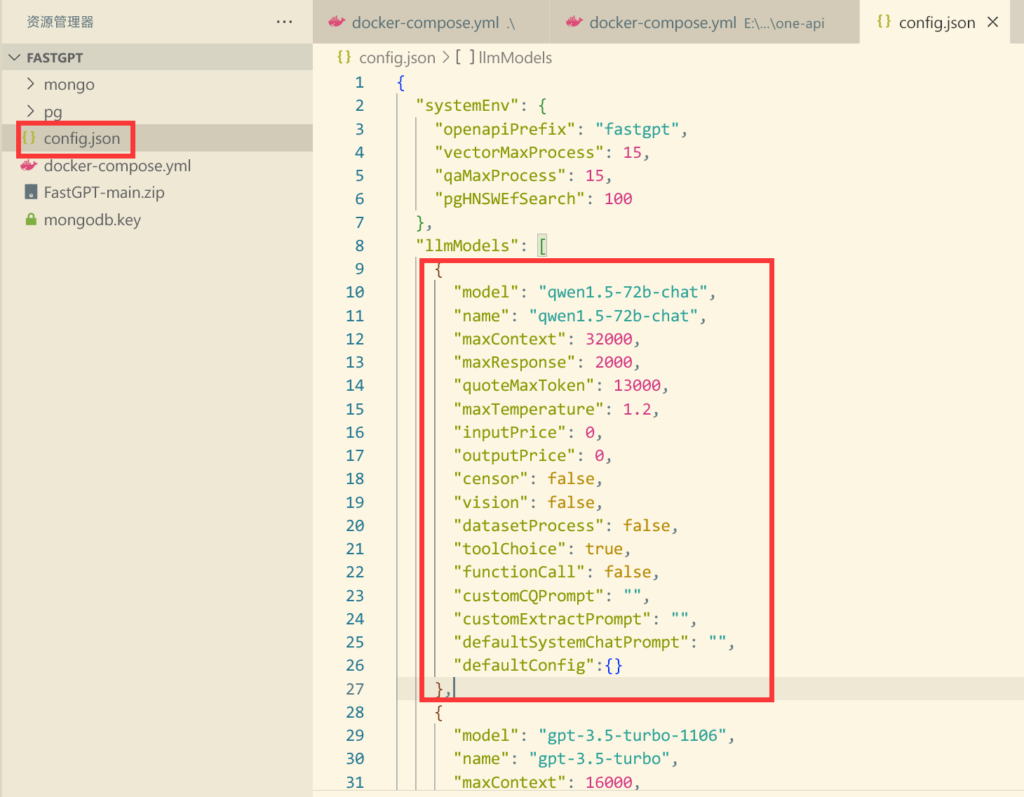

然后在FastGPT的config.json中添加模型信息:(配置文件中已经添加了,而且更新到了最新版本)

{

"model": "gpt-3.5-turbo-1106", // 模型名

"name": "gpt-3.5-turbo", // 别名

"maxContext": 16000, // 最大上下文

"maxResponse": 4000, // 最大回复

"quoteMaxToken": 13000, // 最大引用内容

"maxTemperature": 1.2, // 最大温度

"charsPointsPrice": 0,

"censor": false,

"vision": false, // 是否支持图片输入

"datasetProcess": false, // 是否设置为知识库处理模型(QA),务必保证至少有一个为true,否则知识库会报错

"toolChoice": true, // 是否支持工具选择

"functionCall": false, // 是否支持函数调用

"customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

"customExtractPrompt": "", // 自定义内容提取提示词

"defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

"defaultConfig":{} // 对话默认配置(比如 GLM4 的 top_p

},以上是配置文件的解释。

在FastGPT应用中加入模型即可:

结束

- 分享名称:FastGPT

分享链接:https://kb.itpno.com/#s/-cBmR7Fw

访问密码:iTPno.↩︎

新搭建了一个大模型API集成平台,欢迎来购买;P

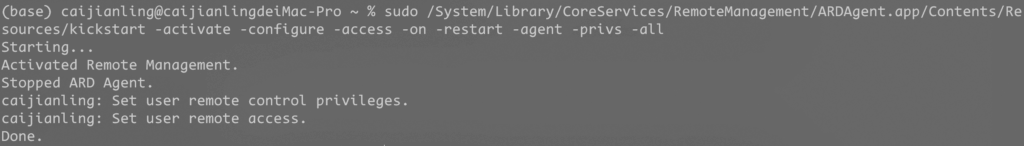

有个问题需要注意:

在 Docker 中使用主机的 localhost 实际上是指向主机的网络接口地址,通常是 127.0.0.1。这个地址用于访问主机上运行的服务,而不是容器内部。在容器中访问主机上的服务时,可以使用主机的 IP 地址或者特殊的主机名,比如 host.docker.internal(仅适用于 Docker for Windows 和 Docker for Mac)或者 docker.for.mac.localhost(仅适用于 Docker for Mac)来代替 localhost。